机器之心 & ArXiv Weekly

参与:楚航、罗若天、梅洪源

本周重要论文包括 AI 绘图神器 ControlNet、Transformer 模型综述等研究。

目录

Transformer models: an introduction and catalog

High-throughout Generative Inference of Large Language Models with a Single GPU

Temporal Domain Generalization with Drift-Aware Dynamic Neural Networks

Large-scale physically accurate modelling of real proton exchange membrane fuel cell with deep learning

A Comprehensive Survey on Pretrained Foundation Models: A History from BERT to ChatGPT

Adding Conditional Control to Text-to-Image Diffusion Models

EVA3D: Compositional 3D Human Generation from 2D image Collections

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

论文 1:Transformer models: an introduction and catalog

作者:Xavier Amatriain

论文地址:https://arxiv.org/pdf/2302.07730.pdf

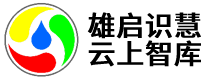

摘要:自 2017 年提出至今,Transformer 模型已经在自然语言处理、计算机视觉等其他领域展现了前所未有的实力,并引发了 ChatGPT 这样的技术突破,人们也提出了各种各样基于原始模型的变体。

由于学界和业界不断提出基于 Transformer 注意力机制的新模型,我们有时很难对这一方向进行归纳总结。近日,领英 AI 产品战略负责人 Xavier Amatriain 的一篇综述性文章或许可以帮助我们解决这一问题。

论文 2:High-throughout Generative Inference of Large Language Models with a Single GPU

作者:Ying Sheng 等

论文地址:https://github.com/FMInference/FlexGen/blob/main/docs/paper.pdf

摘要:传统上,大语言模型(LLM)推理的高计算和内存要求使人们必须使用多个高端 AI 加速器进行训练。本研究探索了如何将 LLM 推理的要求降低到一个消费级 GPU 并实现实用性能。、

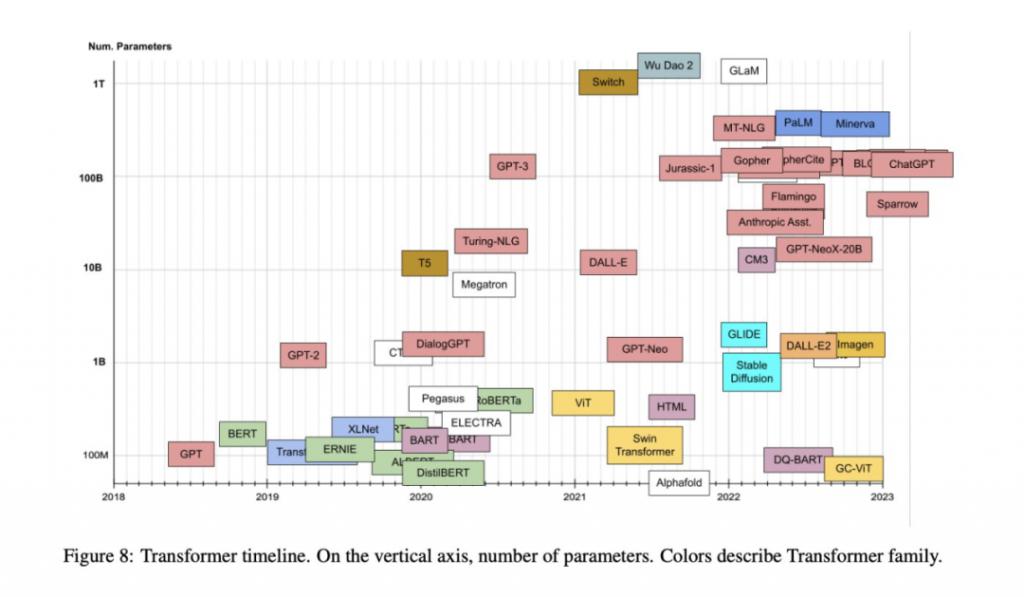

近日,来自斯坦福大学、UC Berkeley、苏黎世联邦理工学院、Yandex、莫斯科国立高等经济学院、Meta、卡耐基梅隆大学等机构的新研究提出了 FlexGen,这是一种用于运行有限 GPU 内存的 LLM 的高吞吐量生成引擎。下图为 FlexGen 的设计思路, 利用块调度来重用权重并将 I/O 与计算重叠,如下图 ( b ) 所示,而其他基线系统使用低效的逐行调度,如下图 ( a ) 所示。

论文 3:Temporal Domain Generalization with Drift-Aware Dynamic Neural Networks

作者:Guangji Bai 等

论文地址:https://arxiv.org/pdf/2205.10664.pdf

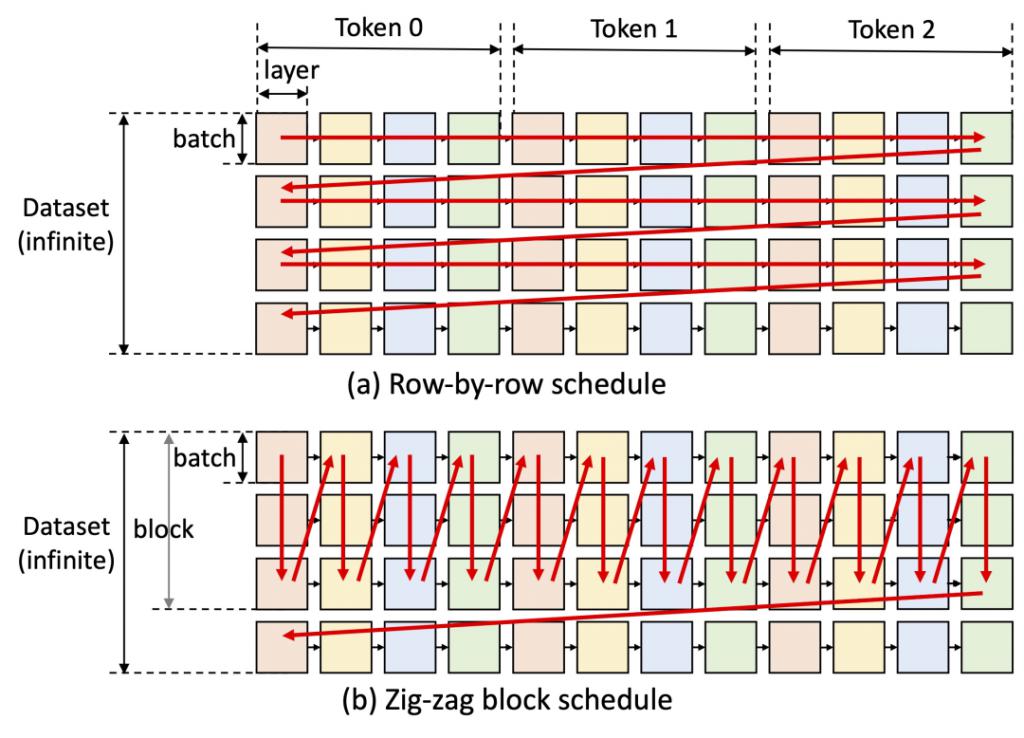

摘要:在领域泛化 ( Domain Generalization, DG ) 任务中,当领域的分布随环境连续变化时,如何准确地捕捉该变化以及其对模型的影响是非常重要但也极富挑战的问题。

为此,来自 Emory 大学的赵亮教授团队,提出了一种基于贝叶斯理论的时间域泛化框架 DRAIN,利用递归网络学习时间维度领域分布的漂移,同时通过动态神经网络以及图生成技术的结合最大化模型的表达能力,实现对未来未知领域上的模型泛化及预测。

本工作已入选 ICLR 2023 Oral ( Top 5% among accepted papers ) 。如下为 DRAIN 总体框架示意图。

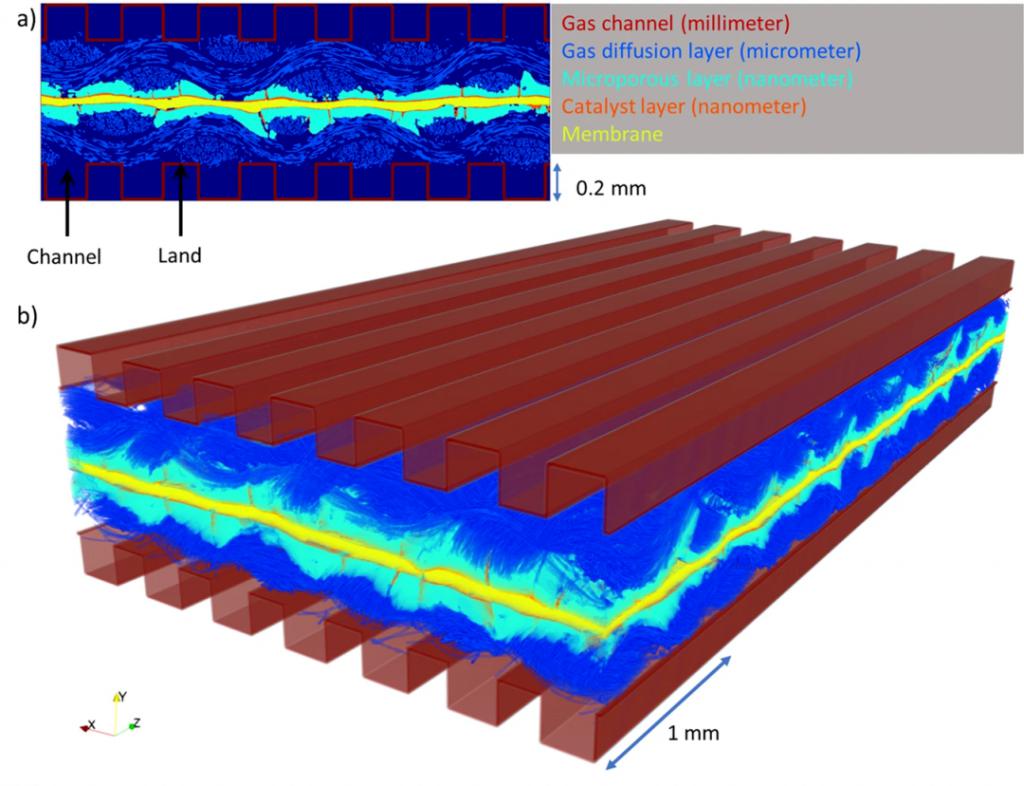

论文 4:Large-scale physically accurate modelling of real proton exchange membrane fuel cell with deep learning

作者:Ying Da Wang 等

论文地址:https://www.nature.com/articles/s41467-023-35973-8

摘要:为了保障能源供应和应对气候变化,人们的焦点从化石燃料转向清洁和可再生能源,氢以其高能密度和清洁低碳的能源属性可以在能源转型变革中发挥重要作用。氢燃料电池,尤其是质子交换膜燃料电池 ( PEMFC ) ,由于高能量转换效率和零排放操作,成为这场绿色革命的关键。

PEMFC 通过电化学过程将氢转化为电能,反应的唯一副产品是纯水。然而,如果水不能正常流出电池,随后「淹没」系统,PEMFC 可能会变得低效。到目前为止,由于燃料电池体积非常小且结构非常复杂,工程师们很难理解燃料电池内部排水或积水的精确方式。

近日,悉尼新南威尔士大学的研究团队开发了一种深度学习算法(DualEDSR),来提高对 PEMFC 内部情况的理解,可以从较低分辨率的 X 射线微计算机断层扫描中生成高分辨率的建模图像。该工艺已经在单个氢燃料电池上进行了测试,可以对其内部进行精确建模,并有可能提高其效率。下图展示了本研究中生成的 PEMFC 域。

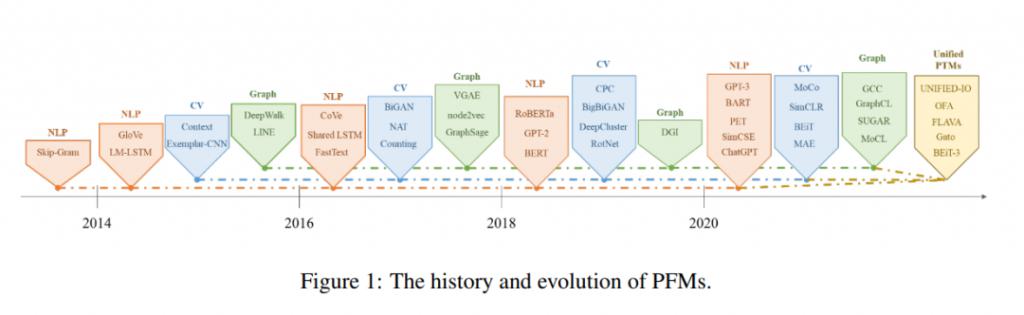

论文 5:A Comprehensive Survey on Pretrained Foundation Models: A History from BERT to ChatGPT

作者:Ce Zhou 等

论文地址:https://arxiv.org/pdf/2302.09419.pdf

摘要:这篇近百页的综述梳理了预训练基础模型的演变史,让我们看到 ChatGPT 是怎么一步一步走向成功的。

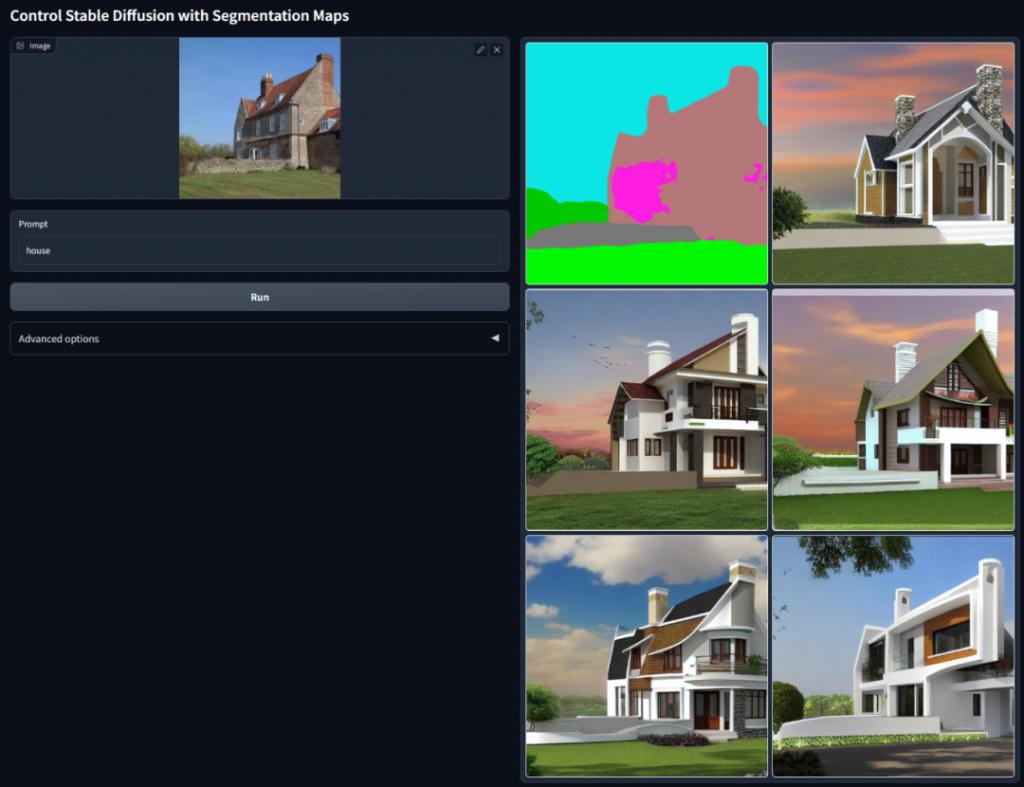

论文 6:Adding Conditional Control to Text-to-Image Diffusion Models

作者:Lvmin Zhang 等

论文地址:https://arxiv.org/pdf/2302.05543.pdf

摘要:本文提出了一种端到端的神经网络架构 ControlNet,该架构可以通过添加额外条件来控制扩散模型(如 Stable Diffusion),从而改善图生图效果,并能实现线稿生成全彩图、生成具有同样深度结构的图、通过手部关键点还能优化手部的生成等。

论文 7:EVA3D: Compositional 3D Human Generation from 2D image Collections

作者:Fangzhou Hong 等

论文地址:https://arxiv.org/abs/2210.04888

摘要:在 ICLR 2023 上,南洋理工大学 - 商汤科技联合研究中心 S-Lab 团队提出了首个从二维图像集合中学习高分辨率三维人体生成的方法 EVA3D。得益于 NeRF 提供的可微渲染,近期的三维生成模型已经在静止物体上达到了很惊艳的效果。但是在人体这种更加复杂且可形变的类别上,三维生成依旧有很大的挑战。

本文提出了一个高效的组合的人体 NeRF 表达,实现了高分辨率(512x256)的三维人体生成,并且没有使用超分模型。EVA3D 在四个大型人体数据集上均大幅超越了已有方案,代码已开源。

ArXiv Weekly Radiostation

机器之心联合由楚航、罗若天、梅洪源发起的 ArXiv Weekly Radiostation,在 7 Papers 的基础上,精选本周更多重要论文,包括 NLP、CV、ML 领域各 10 篇精选 , 并提供音频形式的论文摘要简介,详情如下:

本周 10 篇 NLP 精选论文是:

1. Active Prompting with Chain-of-Thought for Large Language Models. ( from Tong Zhang )

2. Prosodic features improve sentence segmentation and parsing. ( from Mark Steedman )

3. ProsAudit, a prosodic benchmark for self-supervised speech models. ( from Emmanuel Dupoux )

4. Exploring Social Media for Early Detection of Depression in COVID-19 Patients. ( from Jie Yang )

5. Federated Nearest Neighbor Machine Translation. ( from Enhong Chen )

6. SPINDLE: Spinning Raw Text into Lambda Terms with Graph Attention. ( from Michael Moortgat )

7. A Neural Span-Based Continual Named Entity Recognition Model. ( from Qingcai Chen )

本周 10 篇 CV 精选论文是:

1. MERF: Memory-Efficient Radiance Fields for Real-time View Synthesis in Unbounded Scenes. ( from Richard Szeliski, Andreas Geiger )

2. Designing an Encoder for Fast Personalization of Text-to-Image Models. ( from Daniel Cohen-Or )

3. Teaching CLIP to Count to Ten. ( from Michal Irani )

4. Evaluating the Efficacy of Skincare Product: A Realistic Short-Term Facial Pore Simulation. ( from Weisi Lin )

5. Real-Time Damage Detection in Fiber Lifting Ropes Using Convolutiona Neural Networks. ( from Moncef Gabbouj )

6. Embedding Fourier for Ultra-High-Definition Low-Light Image Enhancement. ( from Chen Change Loy )

7. Region-Aware Diffusion for Zero-shot Text-driven Image Editing. ( from Changsheng Xu )

8. Side Adapter Network for Open-Vocabulary Semantic Segmentation. ( from Xiang Bai )

9. VoxFormer: Sparse Voxel Transformer for Camera-based 3D Semantic Scene Completion. ( from Sanja Fidler )

10. Object-Centric Video Prediction via Decoupling of Object Dynamics and Interactions. ( from Sven Behnke )

本周 10 篇 ML 精选论文是:

1. normflows: A PyTorch Package for Normalizing Flows. ( from Bernhard Sch lkopf )

2. Concept Learning for Interpretable Multi-Agent Reinforcement Learning. ( from Katia Sycara )

3. Random Teachers are Good Teachers. ( from Thomas Hofmann )

4. Aligning Text-to-Image Models using Human Feedback. ( from Craig Boutilier, Pieter Abbeel )

5. Change is Hard: A Closer Look at Subpopulation Shift. ( from Dina Katabi )

6. AlpaServe: Statistical Multiplexing with Model Parallelism for Deep Learning Serving. ( from Zhifeng Chen )

7. Diverse Policy Optimization for Structured Action Space. ( from Hongyuan Zha )

8. The Geometry of Mixability. ( from Robert C. Williamson )

9. Does Deep Learning Learn to Abstract? A Systematic Probing Framework. ( from Nanning Zheng )

10. Sequential Counterfactual Risk Minimization. ( from Julien Mairal )

THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com